為何選擇EdgeX?

平臺架構

開發人員、技術提供商和終端使用者能夠通過技術、資源共享和

EdgeX

生態系統的規模經濟(無論是其自己的實踐,還是通過向他人提供商業化的“

EdgeX

就緒型”解決方案),以更低的成本和風險加速實現業務價值。

EdgeX

在許多方面都獨具特色,比如服務範圍、廣泛的行業支援、可信度、投入,以及由 Linux 基金會旗下 LF Edge 組織所提供的不受供應商限制的 Apache 2.0 開源許可模式。

EdgeX

本身也是在所有垂直市場物聯網用例和企業中推動數字轉型與 AI 技術發展的核心要素。

專案服務範圍

EdgeX

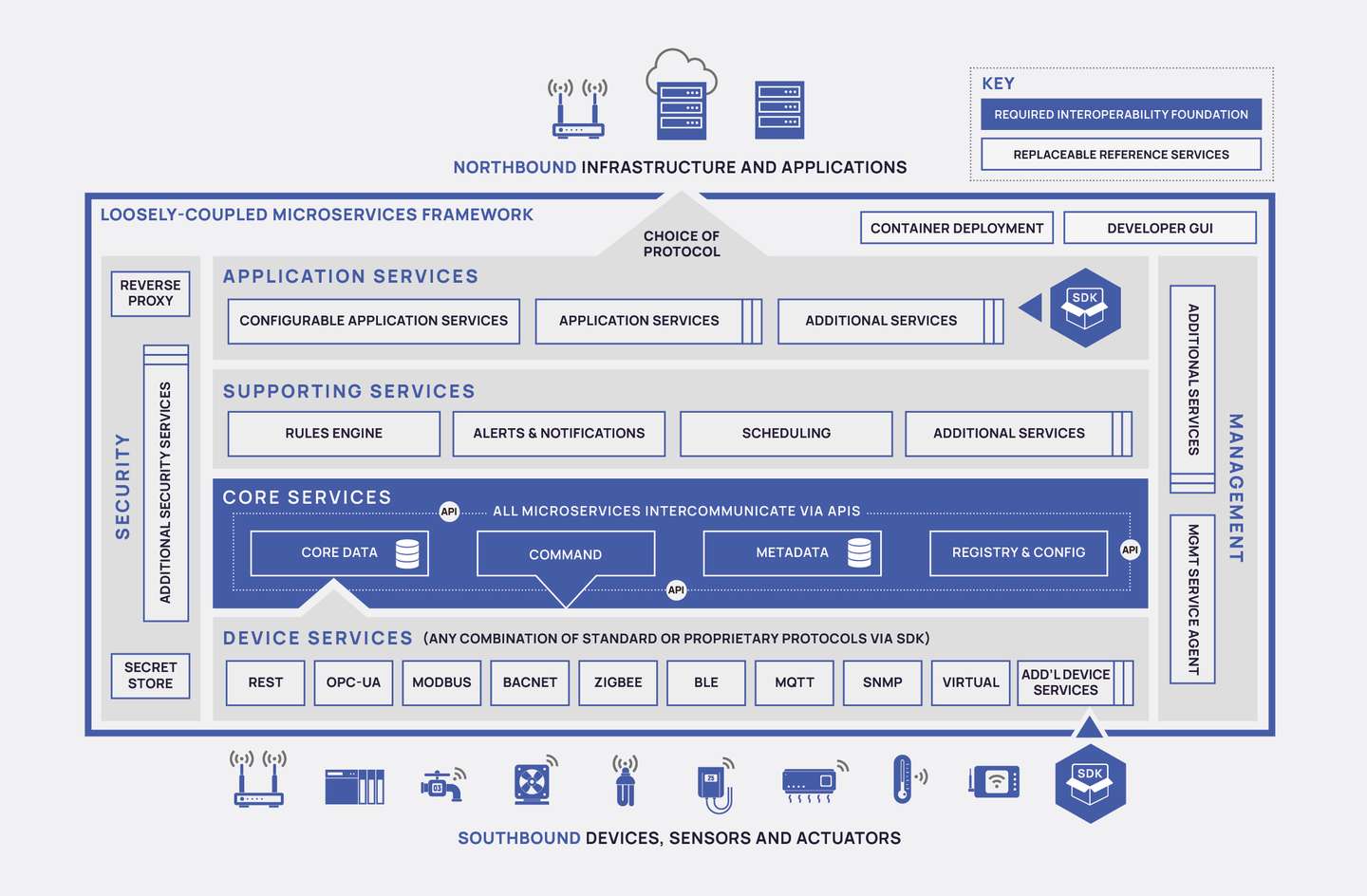

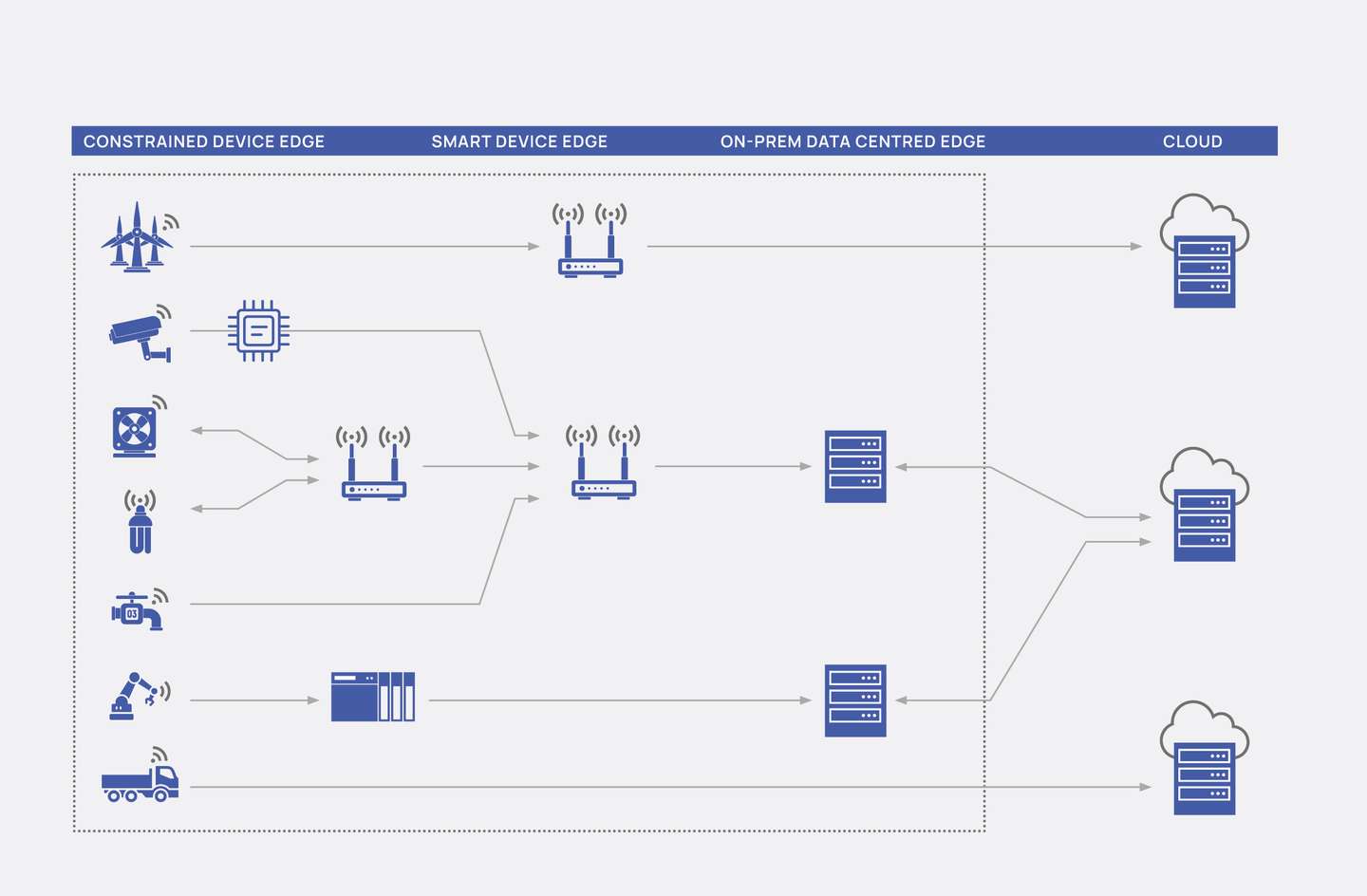

Foundry 專注於充分運用雲原生原則(例如,鬆耦合的微服務、平臺獨立性),以及實現滿足特定物聯網邊緣需求的架構(包括不同的連線協議、廣泛分佈的計算節點的安全性和系統管理,以及縮減高度受限的裝置規模),藉此發揮邊緣計算的優勢。 該專案的“甜蜜點”在於,用例中的本地決策可以實時或以近乎實時的速度進行制定,與此同時,自動化和操作由多個數據源提供支援。在這裡,

EdgeX

可以解決邊緣節點和資料規範化(比如,在分散式物聯網邊緣架構中需滿足“南正對北、東正對西”的條件)方面的關鍵互操作性挑戰。

通過

EdgeX

充分運用邊緣計算帶來的機遇 隨著邊緣計算逐步成為主流,這項技術可以為各行各業提供關鍵策略優勢。瞭解

EdgeX

的使用如何幫助使用者/開發人員實現業務轉型:

可插拔且可擴充套件的軟體架構

-基於現代分散式微服務的軟體架構。容器化支援(例如 docker 或 snap)可實現應用可移植性,並且有助於簡化應用部署和編排。

EdgeX

提供有助於生態系統發展壯大的標準開放式框架。其促進了可互操作的即插即用式軟體應用和增值服務。

端到端連線和互操作性

-邊緣具有與生俱來的異質性和複雜性。資料與“物”的連線依靠多種不同的 OT 通訊標準。

EdgeX

可為關鍵物聯網協議(例如,MQTT、Modbus、BACnet 等)提供參考實踐以及 SDK,以便使用者新增新協議。所有協議以商業生態系統提供的聯結器作為補充,從而使 OT 連線成為一項配置,而非程式設計任務。邊緣系統還必須與多個雲端點和 IT 端點進行整合。

EdgeX

與雲無關,並提供了與不同企業和 IT 環境的靈活連線。

新舊裝置之間的互操作性

-

EdgeX

可以將舊裝置使用的通訊協議轉譯為現代智慧裝置和雲應用能夠理解的語言,從而方便企業將舊技術與現代物聯網平臺銜接在一起。最終,企業無需投資昂貴的新裝置,即可開始使用物聯網,同時還能將新功能的投入降至最低,並迅速從運營中捕獲高階洞見。

確保安全性與合規性

-公司可以使用

EdgeX

輕鬆對關鍵資料和裝置實施防火牆功能和篩選功能,在本地處理資料,並僅將特定資料和應用公開到雲端。

低延遲效能和可擴充套件性

-邊緣應用需要訪問“實時資料”(例如,毫秒/微秒級的響應時間),通常還伴有絕對實時預測的需求。

EdgeX

可滿足以毫秒計的往返響應時間,並且專為在閘道器(一臺搭載標準 Windows 或 Linux 作業系統的伺服器和/或類計算裝置)上執行而設計。

EdgeX

還支援企業策略性地選擇哪些資料需要傳送至雲中,以及哪些資料可以在邊緣以經濟高效的方式進行處理。

在間歇性連線的情況下穩定執行

-

EdgeX

甚至可以在網際網路連接出現中斷或間歇性中斷的情況下,支援製造裝置和其他智慧裝置無中斷執行。這種能力使其非常適合依靠快速分析及操作資料(例如,在沒有網際網路接入的遠端位置、在遠洋船隻上或是因不可預見的原因丟失雲連線的情況下,檢測並響應裝置故障)的企業。

廣泛的市場適用性

-

EdgeX

提供一系列用於支援各垂直行業邊緣計算用例的標準服務,這些行業包括:製造業、零售業、銀行業、運輸業、酒店餐飲業、醫療保健業等。

「其他文章」

- 免費報名:EdgeX技術運用與行業落地大師課

- 技術乾貨丨攝像頭管理功能架構,EdgeX ONVIF/USB 管理和推理平臺

- 萬物互聯|2022第三屆EdgeX中國挑戰賽火熱開場,邀您一起來賽

- 【2021EdgeX中國挑戰賽精選】智慧水文,基於新華三蜂巢邊緣系統(HES)的創新應用

- 為何選擇EdgeX?

- OpenYurt EdgeX:共建生態,打造零侵入式的雲邊端一體化平臺

- 從Device-Simple聊下EdgeX2.0的變化

- EdgeX挑戰賽高階培訓(線上):8月23-27日每天下午2-3點

- 【2021 EdgeX中國挑戰賽 系列培訓】在Ubuntu core上執行基於EdgeX的企業級應用

- 站在AI IoT的風口浪尖,慧博雲通聯合Intel和百度推出全新的雲邊端協同解決方案

- EdgeX中文網站正式上線

- 2021 EdgeX中國挑戰賽盛大開幕,英特爾賦能開發者,助力創新方案落地

- 中國首個 LF Edge 捐贈專案 Baetyl 2.2 正式釋出

- #EII 釋出包資源#

- 【EDGE X K8s Meetup】直播中!

- 今日EdgeX挑戰賽培訓:Intel® Distribution of OpenVINO™

- 今日EdgeX挑戰賽培訓:5G雲化AVG和軟體定義智慧物流

- 關於EdgeX, 我想聽你說

- EdgeX Q1'21 Meetup@上海!一起聚聚!(內含報名方式)

- #EdgeX TSC Meeting 邀請函#