MASA Stack 1.0 釋出會講稿——趨勢篇

世界技術圈在發生什麼?

雲原生的演進

這裡跟大家一起回顧一下張磊老師在雲原生開發者日上關於“雲原生技術演進”的分享。

有很多人會問,是不是雲原生就等於K8s這些開源專案?其實今天出現的這些開源專案如K8s、docker、istio、dapr,是一些概念與方法論的一種技術實現,他們的背後就是雲原生的理論體系,比如不可變的基礎設施,高自動化、自愈自運維,語言和架構無關,高可擴充套件等等,而我們現在在實踐的微服務、容器化、sidecar等就是為了支撐這些概念和方法論的技術和架構實現。這裡有一條邏輯鏈路,就是當有一套概念和方法論之後,就會出現對應的技術和架構,我們在開源社群裡就會出現相應的開源實現。

舉個例子,容器化的技術架構對應的開源實現就有Docker、K8s這樣的開源專案。使用者端體現的這些開源專案,他其實實踐的就是一套技術架構,而在這套技術架構背後的理論思想就是我們說的概念和方法論。整個雲原生生態的體現就是這麼一套方法論加架構加開源技術的這麼一個集合,他的目的就是希望讓雲端計算技術很好的去服務我們的開發者,目標就是幫助開發者降本增效,而云的一些特質就可以幫助我們去實現這一目標,比如雲是無限彈性的,快速的資源交付,還可以按量付費等。

為了讓雲的這些特徵能夠最終幫助開發者降本增效,我們就需要這套邏輯鏈路來達成這個目標,這也是現階段雲原生技術角度來看一個非常自然的演進路線。

除了技術角度之外,我們還可以從時間維度來看雲原生的演進過程。其實開發者希望得到的能力和基礎設施平臺能夠提供的能力之間是有一道很大的鴻溝,開發者要的多,平臺給得少,雲端計算實際上一直在解決這個問題。

時間線越往前,基礎設施越弱,但開發者的訴求其實一直在增長,軟體越寫越複雜,彼此之間的鴻溝會越來越大,這時就會需要有人去填補這個鴻溝。在2010年以前,我相信大家都有聽說過ESB這樣的傳統中介軟體的解決方案,中介軟體顧名思義就是填補在基礎設施和開發者之間鴻溝的一套系統,它的能力非常強,可以滿足開發者開發大型軟體的需求。

隨著時間推移,雲端計算技術越來越成熟,能力越來越豐富,有很多的需求可以用雲的能力直接提供,所有陸續會出現一些比如PaaS這樣的平臺,其實就是雲端計算提供的中介軟體能力。到了2014之後,隨著容器和K8s這樣的技術出現,我們能在雲端計算平臺拿到更多的能力,這是一種非常強大的平臺層的抽象,我們前面講過的不可變基礎設施等都是通過容器、K8s技術實現的,之前需要花很多資源和精力搭建的中介軟體的能力,現在開發者可以非常容易的獲取和實踐,從此開發者的訴求和基礎設施之間的鴻溝不斷的在變小。

隨著時間推移,2020年之後,雲平臺甚至已經開始提供中介軟體的核心能力,比如流量治理,他其實是service mesh的一個核心功能,而Dapr的出現,他進一步的把更多中介軟體能力,包括我們的微服務開發,服務發現、工作流、服務呼叫等,將這些能力下沉到了K8s,進一步的填補了鴻溝。從時間維度我們可以預測,未來雲平臺的能力會越來越強,甚至會超出開發者的訴求,雲端計算的關注點慢慢會從基礎設施的這些運維時,越來越多的向開發時上移。

所以,不管是從技術角度還是時間角度來看,雲原生的核心關注點正在發生變化,他已經滲透到了我們應用開發的各個環節,這就意味著會在某一個時刻,當雲能力足夠多的時候,必然要去關注我們開發者真正的開發過程。

開源軟體的崛起

軟體正在吞噬世界,而開源正在吞噬軟體,擁抱開源是這個時代的開發者應該具備的思維和能力,而擁抱開源能夠讓每一位開發者站在巨人的肩膀上,快速實現業務價值。而開源社群活躍著最優秀、最有活力的開發者,開源專案替代商用軟體是必然趨勢。而云原生技術催生的開源軟體同時解決了企業卡脖子的問題,不被某一家雲廠商所繫結。

我們發現,開源軟體已經無孔不入,在原有的商用軟體的各個領域都有開源軟體的替代,開源軟體正在崛起。所以我們毅然決然的選擇開源我們的MASA Stack及MASA的系列產品。

為什麼選擇開源?

1. 豐富.NET的開源生態,為.NET技術生態做出我們應有的貢獻 2. 希望全世界的.NET開發者能夠評審我們的程式碼,要求我們更開放、更規範、更嚴謹 3. 也希望.NET開發者能夠參與進來,社群驅動,讓產品更健壯,更有未來

戰略技術趨勢

下面我們來看一下權威機構Gartner釋出的2023年戰略技術趨勢,以上10個技術趨勢我們來關注一下數字免疫系統、應用可觀測性、自適應AI和平臺工程。

平臺工程

不管是DevOps還是AIOps,各種Ops解決的就是將開發和運維達成有機運轉的協作狀態,是非常不錯的方法論,但每個組織的落地卻參差不齊,並不理想,導致開發人員需要直面苦澀的K8s等基礎架構的知識體系。

平臺工程是將複雜的基礎設施能力通過平臺的方式整合並形成自助式的開發者門戶,目標是優化開發者體驗並加快產品團隊為客戶創造價值的速度,讓變化更簡單。讓運維人員更加關注開發人員的交付體驗、應用服務的安全性和穩定性,開發人員不再感知基礎設施,更加關注業務實現。平臺工程是雲原生技術運維時到開發時的產品形態。

Gartner預測,到2026年,80%的軟體工程組織將建立平臺團隊,其中75%將包含開發者自助服務門戶。自MASA Stack誕生以來,我們的產品定位就是企業級雲原生技術底座,方便大家理解我們加上了一個PaaS的補充說明,Gartner在合適的時間給了我們一個合適的叫法,那就是平臺工程,我們今天正式把MASA Stack定位為平臺工程!

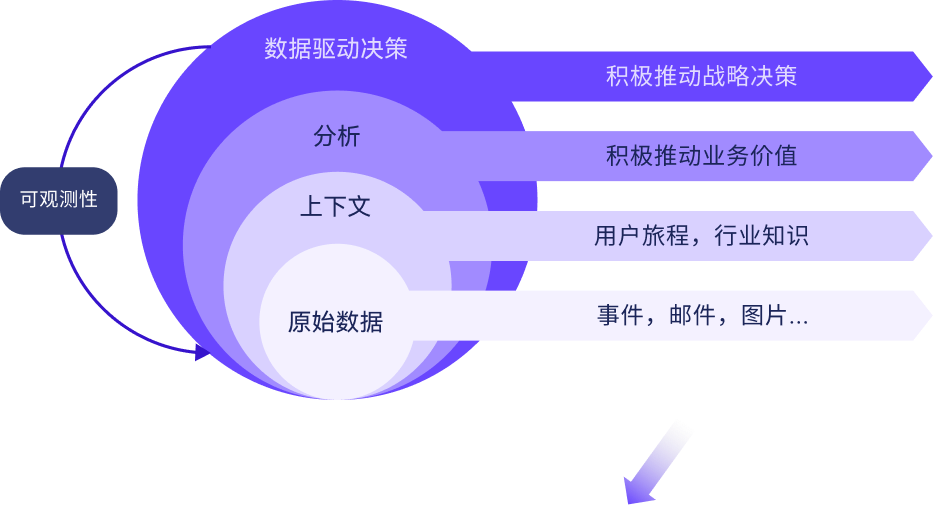

可觀測性

數字化時代的核心標誌是資料驅動智慧運營與商業創新,而擁有應用可觀測性使企業夠利用他們資料驅動決策來獲得競爭優勢。它能夠在正確的時間提供正確資料,從而使企業在不確定的時代快速響應,讓變化更簡單。可觀測性是MASA Stack的核心能力之一,我們在每個版本會持續迭代增強。

自適應AI

現階段AI技術已經融入到企業生產作業的方方面面,如自然語言處理、機器視覺、流程自動化、智慧推薦、分析預測等技術被應用到了像RPA數字員工、輿情監控、預測性維護、客戶畫像、商品推薦、機器人客服等場景。自適應AI是通過不斷反覆訓練模型,在執行和開發環境中不斷的使用新的資料進行學習,從而實現敏捷運營,快速自適應。更多的企業正在嘗試用AI代替人去做重複性、低難度的工作,讓員工去做更有創造力的工作,實現企業願景,獲得員工個人價值實現。

數字免疫系統

76%負責數字產品的團隊需要對營收負責,企業需要一個能在實現高商業價值的同時,降低風險和提高客戶滿意度的方法,數字免疫系統能滿足這一要求。

數字免疫系統通過結合資料驅動的可觀測性、AI增強測試、混沌工程、自動修復,SRE,軟體供應鏈安全等技術手段來提高系統的彈性和穩定性。

Gartner預測,到2025年,投資建設數字免疫系統的企業機構將能夠減少多達80%的系統宕機時間,所減少的損失將直接轉化為更高的收入。從某種層面上來說,平臺工程、應用可觀測性和自適應AI直接促成了數字免疫系統的實現。

應用現代化

如何應對不確定性

國內外市場多重不確定性對企業持續增長提出考驗,不確定性時代最大的特點是變化,客戶需求在變、技術潮流在變,要想跟上變化,就需要擁有實時洞察和快速響應個性化、場景化、定製化需求的平臺能力,打造可組裝模組化應用的能力,用組裝式的應用架構來呼應組裝式的業務架構。

企業首先需要擁有一套無邊界的平臺底座,也就是數字底座,再將已有的資訊化系統進行中臺化、服務化重構,構建領域服務群,結合第三方生態及行業解決方案,最終打造統一的企業自有的數字化平臺,這是數字化轉型的必要路徑。第一步需要攻克的難題,就是要將老舊的系統進行現代化升級,那麼什麼是應用現代化呢?

應用現代化

IDC的2022中國雲端計算市場預測中,應用現代化位列第一,到2024年,大多數遺留應用將實現一定程度的現代化投資。55%的應用將使用雲服務來擴充套件功能或替換低效程式碼。應用現代化也已成為一種共識,華為雲認為應用現代化是以軟體的敏捷交付為導向,實現貫穿基礎設施到應用的認知重塑、架構升級和技術躍遷。

AWS認為應用現代化是採用最新技術構建,是開發組織加快創新、提高效能、安全性和可靠性,同時降低總擁有成本的解決方案。微軟雲認為應用現代化是通過使用具有鬆散耦合微服務、託管資料庫、Al、DevOps 支援和內建監控的雲原生架構來快速創新。

IBM認為應用現代化是對現有舊應用(單體、本地、瀑布式開發) 的平臺基礎架構、內部架構和功能進行現代化(雲原生、微服務、DevOps) 改造的過程。應用現代化是數字化轉型的必備能力,是應用開發的新正規化。

關於我們

但很少有人關心.NET應用現代化的解決方案,我們MASA就此誕生了,MASA就是現代化應用和服務架構的意思,我們致力於用.NET技術賦能開發者,使用MASA Stack及MASA的系列開源解決方案幫助企業對老舊的應用進行現代化改造,幫助企業.NET技術團隊擁抱雲原生,平滑的升級技術架構和知識體系,直接幫助企業降低數字化轉型門檻,幫助企業快速試錯,快速創新,應對不確定性,讓變化更簡單!

一站式解決方案

相比JAVA成熟的開源技術生態,.NET開源生態的現狀確實有點不如人意,於是我們決定提供前端、後端、平臺工程一站式的應用現代化解決方案。

MASA Blazor

在前端我們基於Material Design打造了企業級多端元件庫MASA Blazor,使用.NET實現全棧解決方案,具有模組化、響應式和優秀的效能,搭配MAUI使用在移動端、桌面端都有極佳的效果。

MASA Framework

在後端我們提供了微服務開發框架MASA Framework,我們把他定義為.NET下一代微服務開發框架,內嵌分散式執行時——Dapr雲原生最佳實踐,能夠快速實現分散式、微服務、DDD、SaaS等現代化應用開發。我們參考Dapr的優秀設計,提供了20項Building Blocks,還有MASA Stack各項能力的SDK支援。MASA Framework在2022年開辦了公開課,已經出了6期的課程,有興趣的朋友可以關注進來。

MASA Stack

最後就是我們的核心開源產品MASA Stack,MASA Stack是開源企業級開發者門戶——平臺工程,包含企業IT現代化應用開發交付的全部板塊,如應用治理、服務編排與整合、資料開發與治理、可觀測性、DevOps研發協作、AI智慧等一站式解決方案。MASA Stack 1.0發版的同時,我們會一併釋出MASA Blazor和MASA Framework的1.0版本。

願景

我們再來聊聊我們的願景,我們MASA希望在影響力上成為.NET技術生態中Spring的存在,成為.NET現代應用開發的標配。MASA Framework可以比肩Spring boot,MASA Stack 可以比肩Spring Cloud,但我們不僅僅只是比肩,我們還能超越!

MASA Stack 1.0 釋出會——趨勢篇.pdf掃碼觀看回放

如果你對我們的開源專案感興趣,無論是程式碼貢獻、使用、提 Issue,歡迎聯絡我們

- Blazor在IoT領域的前端實踐 @.NET開發者日

- MASA MAUI Plugin (十)iOS訊息推送(原生APNS方式)

- MASA MAUI Plugin (九)Android相簿多選照片(使用Android Jetpack套件庫)

- MASA MAUI Plugin (八)Android相簿多選照片(Intent 方式)

- MASA Stack 1.0 釋出會講稿——生態篇

- MASA Stack 1.0 釋出會講稿——實踐篇

- MASA Stack 1.0 釋出會講稿——產品篇

- MASA Stack 1.0 釋出會講稿——趨勢篇

- MASA MAUI Plugin (七)應用通知角標(小紅點)Android iOS

- .NET現代化應用開發 - CQRS&類目管理程式碼剖析

- MASA MAUI Plugin 安卓藍芽低功耗(二)藍芽通訊

- MASA MAUI Plugin 安卓藍芽低功耗(一)藍芽掃描

- MASA MAUI Plugin 安卓藍芽低功耗(二)藍芽通訊

- MASA MAUI Plugin 安卓藍芽低功耗(一)藍芽掃描

- MASA Framework的分散式鎖設計

- MAUI Masa Blazor 開發介面跟隨系統主題切換的App

- MAUI Masa Blazor 開發介面跟隨系統主題切換的App

- MAUI Masa Blazor 開發帶自動更新功能的安卓App

- 開篇-開啟全新的.NET現代應用開發體驗

- 怎麼樣的框架對於開發者是友好的?